數據湖存儲格式Hudi 原理與實踐在數據處理與存儲服務中的應用

數據湖已成為現代數據架構的核心組成部分,而Apache Hudi(Hadoop Upserts and Incrementals)作為一種高效的數據湖存儲格式,在數據處理和存儲支持服務中發揮著關鍵作用。本文將從Hudi的基本原理出發,探討其在實際應用中的實踐價值,重點關注其對數據處理流程和存儲服務的優化支持。

一、Hudi的核心原理

Hudi旨在為數據湖提供增量處理和更新能力,解決了傳統數據湖面臨的更新和刪除操作效率低下的問題。其核心原理包括:

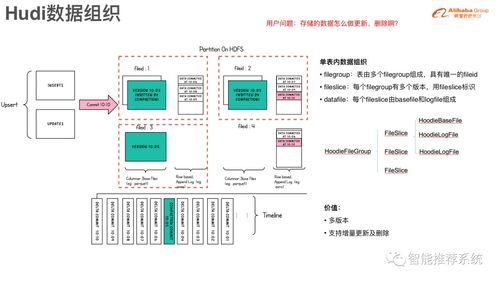

- 數據組織與索引機制:Hudi通過文件分組和全局索引,將數據劃分為基本文件(Base File)和增量日志文件(Delta Log),支持高效的更新和刪除操作。索引機制允許快速定位數據記錄所在文件,避免全表掃描。

- 事務處理與并發控制:Hudi支持ACID事務,確保數據一致性。通過樂觀并發控制,允許多個寫入操作同時進行,而不會破壞數據完整性。

- 表類型和查詢類型:Hudi提供兩種表類型——Copy-on-Write(COW)和Merge-on-Read(MOR),以及兩種查詢類型——快照查詢和增量查詢。COW表在寫入時直接更新數據文件,適合讀密集型場景;MOR表則延遲合并,適合寫密集型場景。

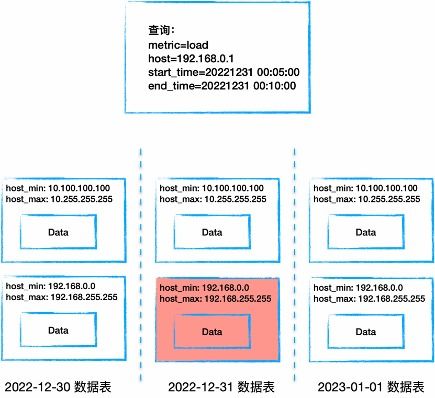

- 增量數據處理:Hudi內置了對增量數據管道的支持,允許用戶僅處理自上次處理以來的變更數據,顯著減少計算和存儲開銷。

二、Hudi在數據處理中的應用實踐

在數據處理服務中,Hudi通過其高效的數據管理能力,提升了整個數據管道的性能:

- 實時數據攝取:Hudi支持從Kafka、Flink等流數據源實時攝取數據,并通過增量更新機制,確保數據湖中的信息始終最新。例如,在電商場景中,用戶行為數據可以實時寫入Hudi表,支持后續的實時分析。

- 數據更新與刪除:傳統數據湖難以處理更新和刪除操作,而Hudi通過Upsert(插入或更新)和Delete功能,簡化了數據維護。例如,在客戶數據管理中,可以輕松更新客戶信息或刪除重復記錄。

- 增量ETL流程:Hudi的增量查詢功能使得ETL(提取、轉換、加載)流程更加高效。數據處理服務可以僅處理自上次ETL運行以來的變更數據,減少資源消耗并加快處理速度。

- 數據版本管理:Hudi支持時間旅行查詢,用戶可以訪問歷史版本的數據,便于審計、回滾或分析數據演變趨勢。

三、Hudi在存儲支持服務中的優勢

作為數據湖存儲格式,Hudi為存儲服務帶來了顯著的改進:

- 存儲效率優化:Hudi通過文件壓縮和合并策略,減少了存儲空間的占用。例如,在MOR表中,增量日志文件可以定期合并到基本文件中,降低存儲成本。

- 查詢性能提升:Hudi的索引和分區機制加速了數據檢索。結合查詢引擎如Apache Spark或Presto,用戶可以快速執行復雜查詢,支持即席分析和報表生成。

- 數據生命周期管理:Hudi提供了工具來自動管理數據的生命周期,包括清理舊版本數據和歸檔過期數據,幫助存儲服務保持高效和可擴展性。

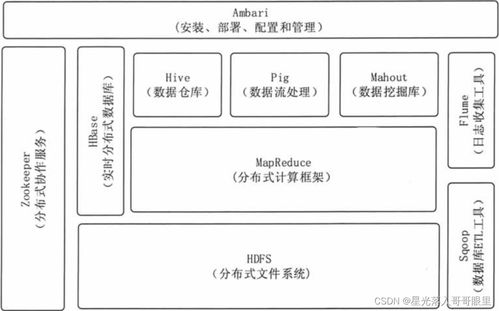

- 多引擎兼容性:Hudi與多種大數據引擎(如Spark、Flink、Hive)無縫集成,使得存儲服務能夠靈活適應不同的數據處理需求,構建統一的數據平臺。

四、實踐案例與最佳實踐

在實際部署中,企業可以遵循以下最佳實踐來最大化Hudi的價值:

- 選擇合適的表類型:根據讀寫比例選擇COW或MOR表。如果讀操作頻繁,COW表更合適;如果寫操作占主導,MOR表能提供更好的性能。

- 優化索引配置:根據數據規模調整索引類型(如布隆索引或全局索引),以平衡寫入延遲和查詢性能。

- 監控與調優:定期監控Hudi表的性能指標,如文件大小、合并頻率等,并根據負載進行調整,確保系統穩定運行。

例如,某金融機構使用Hudi構建實時數據湖,處理每日數TB的交易數據。通過Hudi的增量更新機制,他們實現了交易數據的近實時分析,同時將存儲成本降低了30%。

結論

Apache Hudi作為一種先進的數據湖存儲格式,通過其強大的更新、刪除和增量處理能力,顯著提升了數據處理和存儲支持服務的效率。在數據驅動的時代,Hudi幫助企業構建靈活、可擴展的數據架構,支持從批處理到實時分析的多樣化需求。隨著技術的演進,Hudi將繼續在數據湖生態中扮演關鍵角色,推動數據處理服務的創新與發展。通過深入理解其原理并應用于實踐,組織可以釋放數據潛力,加速數字化轉型。

如若轉載,請注明出處:http://m.520lj.com.cn/product/13.html

更新時間:2026-02-10 16:11:17