etcd詳解 Raft算法如何保證強一致性,及其數據處理與存儲對服務的支持

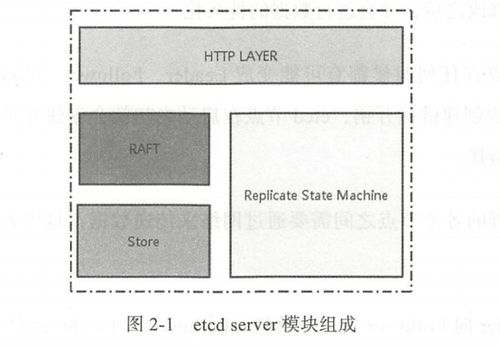

etcd是一個高可用的分布式鍵值存儲系統,由CoreOS團隊開發,現已成為Kubernetes等眾多云原生系統的核心數據樞紐。它以其強大的一致性保證和可靠性著稱,這主要歸功于其底層采用的Raft共識算法。etcd高效的數據處理與存儲機制,為上層服務提供了堅實的數據基礎。本文將深入解析Raft算法如何確保etcd的強一致性,并闡述其數據處理與存儲如何支撐服務。

一、核心基石:Raft共識算法與強一致性保證

etcd的核心設計目標是提供強一致性的分布式數據存儲。這意味著,在任意時刻,從集群中任何一個健康的節點讀取到的數據,都是最新且相同的。Raft算法正是實現這一目標的關鍵。

1. Raft算法簡述

Raft是一種易于理解的共識算法,它將一致性問題分解為幾個相對獨立的子問題:領導者選舉、日志復制和安全性。etcd集群通常由奇數個節點(如3、5、7個)組成,每個節點在Raft中扮演以下三種角色之一:

- 領導者:集群中唯一處理所有客戶端寫請求的節點,負責將數據變更復制到其他節點。

- 跟隨者:被動響應來自領導者的日志復制請求和候選人的選舉請求。

- 候選人:在選舉超時后,發起新一輪領導者選舉的臨時狀態。

2. 保證強一致性的關鍵機制

領導者唯一性與日志順序性:所有寫請求都必須通過領導者。領導者將每個寫操作(例如 put key value)作為一個日志條目,按順序追加到自己的日志中,然后并行地復制給所有跟隨者。只有當超過半數節點成功持久化該日志條目后,領導者才認為該條目是已提交的,隨后將其應用到自己的狀態機(即實際的鍵值存儲中)并通知客戶端寫入成功。這個“大多數節點確認”的機制確保了即使在部分節點故障時,已提交的數據也不會丟失。

日志匹配與安全性約束:Raft通過嚴格的規則確保所有節點最終擁有一致的日志序列。這包括:選舉時,只有擁有最新日志的節點才能成為領導者;領導者會強制覆蓋跟隨者中與自己沖突的日志部分,確保所有節點日志最終一致。

* 線性化讀寫:etcd默認提供線性一致性(最強的一致性模型)。對于讀請求,etcd也通過領導者處理(或通過一種稱為ReadIndex的機制,在不增加日志的情況下由領導者確認自己的領導權),從而確保讀取到的永遠是最新的、已提交的數據,避免了臟讀。

正是通過這些機制,Raft算法在容忍少數節點故障(如一個3節點集群可容忍1個節點故障)的前提下,為etcd提供了強大的強一致性和高可用性保障。

二、數據處理與存儲:服務的堅實后盾

在Raft保證了數據的正確性與一致性的基礎上,etcd自身高效的數據處理與存儲設計,使其能夠成為高性能的服務基礎設施。

1. 數據模型與接口

鍵值存儲:etcd的數據模型非常簡單,是一個分層的鍵值空間。鍵是以/分隔的字節數組,類似于文件系統路徑,天然支持組織結構和前綴查詢。

豐富的操作:除了基本的Put、Get、Delete,etcd支持事務、原子比較并交換、租約(帶TTL的鍵)、監聽鍵前綴變化等。這些特性使得服務可以方便地實現配置管理、服務發現、分布式鎖、領導者選舉等模式。

2. 存儲引擎:MVCC與BoltDB

etcd采用多版本并發控制存儲引擎。

- MVCC:每一次對鍵的修改(

Put)都會生成一個新的修訂版本號,舊的數據不會被立即刪除。這為系統帶來了巨大好處: - 無鎖讀:讀操作可以訪問一個歷史快照,完全不需要阻塞寫操作,極大地提升了并發讀性能。

- 歷史版本查詢與監聽:客戶端可以查詢任意修訂版本的數據,或者監聽從某個修訂版本開始的所有變更。這是Kubernetes實現

list-watch機制、進行狀態同步的基礎。

- 后端存儲:etcd v3版本使用BoltDB(一個單機的嵌入式鍵值數據庫)作為默認后端存儲。BoltDB提供穩定的事務支持,且數據以B+樹形式組織,對于etcd的鍵范圍查詢和前綴掃描非常高效。所有數據(包括鍵值對、修訂版本索引等)都持久化在單個文件中,易于備份和管理。

3. 對上層服務的支持

配置管理:服務可以將動態配置存儲在etcd中,并通過監聽機制實時獲取配置更新,實現配置的集中化管理和動態生效。

服務發現:服務實例啟動時,可以在etcd中注冊自己的網絡地址信息(創建一個帶租約的鍵)。其他服務或負載均衡器通過查詢etcd來發現可用的服務實例。當實例故障時,其租約過期,鍵被自動刪除,實現自動下線。

分布式協調:利用etcd的事務、CAS操作和租約,可以輕松構建分布式鎖、隊列或領導者選舉功能,協調多個服務實例的行為,避免沖突。

元數據存儲:正如Kubernetes所做的那樣,etcd是存儲整個系統期望狀態和實際狀態的事實來源。其強一致性保證了調度器等組件做出決策時基于的是最新的集群狀態。

###

etcd的成功在于它將理論(Raft共識算法) 與工程實現(MVCC存儲、高效API) 完美結合。Raft算法通過領導者選舉、日志復制和安全性規則,在分布式環境中構建了一個強一致性的“虛擬狀態機”,這是etcd可靠性的根基。而在此基礎上,其簡潔的鍵值模型、MVCC存儲引擎以及豐富的原子操作,則為構建高可用的分布式服務提供了強大、靈活且可靠的數據基石。理解etcd的這兩個層面,對于設計和運維依賴它的云原生系統至關重要。

如若轉載,請注明出處:http://m.520lj.com.cn/product/35.html

更新時間:2026-02-10 20:14:29