一文深入掌握Druid 實時與歷史數據處理與存儲的核心引擎

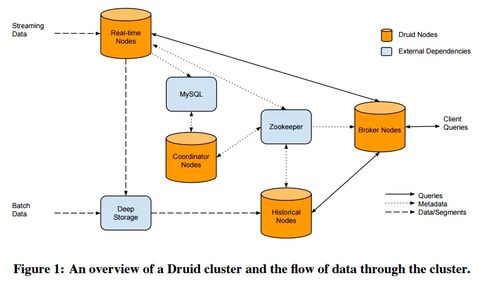

Druid是一個專為實時和歷史數據分析而設計的高性能、列式存儲、分布式數據存儲系統。它能夠高效地處理大規模的事件流數據,并支持低延遲的查詢,廣泛應用于實時監控、廣告技術、物聯網(IoT)和業務智能(BI)等場景。本文將深入探討Druid的數據處理流程、存儲架構以及其核心支持服務,幫助您全面掌握這一強大的數據處理引擎。

一、Druid的核心設計哲學與優勢

Druid的設計目標是解決大數據場景下的實時攝入、快速查詢和高可用性問題。其主要優勢包括:

- 列式存儲與高效壓縮:數據按列存儲,便于壓縮和快速聚合查詢,顯著減少I/O。

- 分布式架構:支持水平擴展,能夠處理PB級數據。

- 實時與批量攝入:支持從Kafka等流式數據源實時攝入,也支持從HDFS等批量導入歷史數據。

- 預聚合與索引:通過數據段(Segment)的預聚合和位圖索引,實現亞秒級查詢響應。

- 時間分區:數據按時間分區,便于數據管理和時效性查詢。

二、數據處理流程:從攝入到查詢

Druid的數據處理流程主要包括三個關鍵階段:

- 數據攝入(Ingestion):

- 實時攝入:通過“索引服務”(Indexing Service)從Kafka、Kinesis等流式數據源持續拉取數據,并實時創建數據段。

- 批量攝入:通過“Hadoop索引任務”或本地任務,從靜態文件(如JSON、Parquet)批量導入數據。攝入過程中,Druid會對數據進行解析、轉換(如維度、度量定義)和聚合(如roll-up)。

- 數據存儲與段管理:

- 攝入的數據被劃分為不可變的“段”(Segment),每個段包含特定時間范圍的數據。段是Druid存儲、復制和負載均衡的基本單元。

- 段存儲在“深度存儲”(Deep Storage,如HDFS、S3)中作為持久化備份,同時被加載到“歷史節點”(Historical Node)的內存和本地磁盤供查詢使用。

- 查詢執行:

- 查詢通過“Broker節點”接收,Broker根據查詢的時間范圍,從“協調節點”(Coordinator)獲取段分布信息,并將查詢路由到相應的Historical節點或實時任務節點。

- 各節點并行執行查詢(如聚合、過濾),Broker合并結果返回給客戶端。

三、核心存儲架構與支持服務

Druid的架構由多個相互協作的專用服務組成,每個服務負責特定功能,共同支撐數據處理與存儲:

- 協調節點(Coordinator):

- 管理集群上的數據段,包括監控Historical節點、將新段分配給節點、平衡負載、刪除舊數據(基于保留規則)。它定期從元數據存儲(如MySQL、PostgreSQL)讀取段信息,并發布負載規則。

- 歷史節點(Historical Node):

- 負責加載和提供數據段的查詢服務。它從深度存儲下載段到本地,并常駐內存以提供快速查詢。Historical節點是無狀態的,易于擴展。

- 代理節點(Broker Node):

- 作為查詢的入口點,接收來自客戶端的查詢(通過REST或JDBC)。它從Coordinator獲取段分布信息,將查詢轉發給相應的Historical或實時節點,并合并結果。Broker還緩存查詢結果以提升性能。

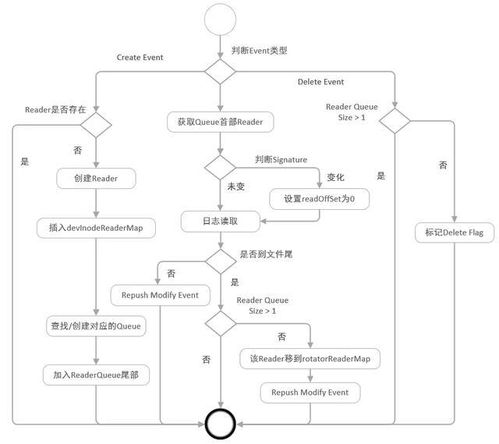

- 索引服務(Indexing Service):

- 負責數據的攝入和段的創建。它由“Overlord”(主節點)和“MiddleManager”(工作節點)組成。Overlord分配攝入任務,MiddleManager執行任務(如從Kafka拉取數據并生成段)。生成的段被推送到深度存儲,并由Coordinator協調加載到Historical節點。

- 實時節點(已演進):

- 早期版本有專門的實時節點,現在實時攝入功能已集成到索引服務中。MiddleManager可以運行實時任務,在內存中緩存實時數據,并定期將數據轉換為不可變的段。

- 元數據存儲與深度存儲:

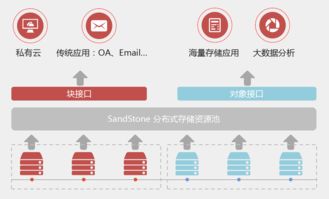

- 元數據存儲:通常使用關系型數據庫(如MySQL),存儲段的元數據、配置信息和任務日志。這是集群的“大腦”信息庫。

- 深度存儲:使用分布式文件系統(如HDFS、S3)或對象存儲,作為數據段的持久化備份。Historical節點從深度存儲加載段,確保數據可靠性和可恢復性。

四、關鍵特性深入解析

- 數據段(Segment)的結構:每個段是一個時間分塊的數據集合,包含:

- 列式存儲文件:數據按列存儲,包括時間戳、維度(字符串)和度量(數值)。維度列還創建了位圖索引,支持快速過濾。

- 索引文件:包含元數據和位圖索引,加速查詢。

- Roll-up預聚合:在攝入階段,Druid可以對數據進行聚合(如按維度組合求和、計數),減少存儲空間并提升查詢速度。但會丟失原始粒度數據,需在數據模型設計時權衡。

- 多租戶與隔離:通過任務分配和資源隔離,Druid支持多租戶使用,不同數據源或團隊可以共享集群而互不影響。

- 容錯與高可用:

- 服務本身設計為無單點故障,可以部署多個Coordinator和Overlord實例(通過選舉產生領導者)。

- 數據段在深度存儲有備份,且在Historical節點間可復制,確保節點故障時數據不丟失。

五、實踐建議與最佳實踐

- 數據模型設計:合理選擇維度(用于分組和過濾)和度量(用于聚合),根據查詢模式決定是否啟用roll-up。

- 集群規劃:根據數據規模、查詢并發和實時性要求,合理配置各服務節點數量。例如,高查詢負載需增加Broker和Historical節點。

- 監控與調優:利用Druid內置的指標(如查詢延遲、段加載狀態)和日志,監控集群健康。調整段大小(通常每段500MB以下)、內存配置和緩存策略以優化性能。

- 與生態集成:Druid可與Apache Superset、Grafana等可視化工具集成,也支持通過Kafka Connect、Flink等工具進行數據攝入。

Druid通過其獨特的列式存儲、分布式架構和專用服務組件,實現了大規模實時與歷史數據的高效處理和存儲。掌握其數據處理流程和核心服務——Coordinator、Historical、Broker和Indexing Service的協作機制,是構建低延遲分析應用的關鍵。隨著實時分析需求的增長,Druid已成為現代數據棧中不可或缺的一環,值得每一位數據工程師和架構師深入學習和應用。

如若轉載,請注明出處:http://m.520lj.com.cn/product/40.html

更新時間:2026-02-10 13:27:16