Hadoop與Spark 大數(shù)據(jù)時代的處理與存儲雙引擎

在大數(shù)據(jù)時代,高效的數(shù)據(jù)處理與存儲技術(shù)是企業(yè)挖掘數(shù)據(jù)價值的關(guān)鍵。Hadoop和Spark是這一領(lǐng)域中最為核心和廣泛應(yīng)用的兩個開源框架,它們共同構(gòu)成了現(xiàn)代大數(shù)據(jù)生態(tài)系統(tǒng)的基石,為企業(yè)提供了強大的數(shù)據(jù)處理和存儲支持服務(wù)。

一、Hadoop:分布式存儲與批處理的奠基者

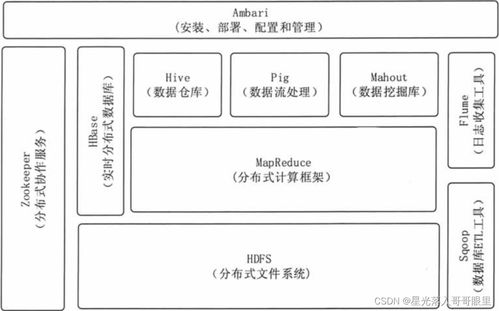

Hadoop是一個由Apache軟件基金會開發(fā)的分布式系統(tǒng)基礎(chǔ)架構(gòu),其核心設(shè)計目標是能夠以可靠、可擴展的方式存儲和處理海量數(shù)據(jù)(從GB到PB級別)。它主要解決了兩個根本問題:海量數(shù)據(jù)的存儲和大規(guī)模數(shù)據(jù)的批處理計算。

- 核心組件與存儲支持:

- HDFS (Hadoop Distributed File System):這是Hadoop的存儲基石。它將大文件分割成多個數(shù)據(jù)塊(默認為128MB或256MB),并分布式地存儲在一個由普通商用服務(wù)器組成的集群中。HDFS具有高容錯性,通過多副本機制(默認3副本)確保數(shù)據(jù)安全,即使部分節(jié)點失效,數(shù)據(jù)也不會丟失。它提供了高吞吐量的數(shù)據(jù)訪問能力,非常適合一次寫入、多次讀取的場景,如日志文件、歷史數(shù)據(jù)存檔等。

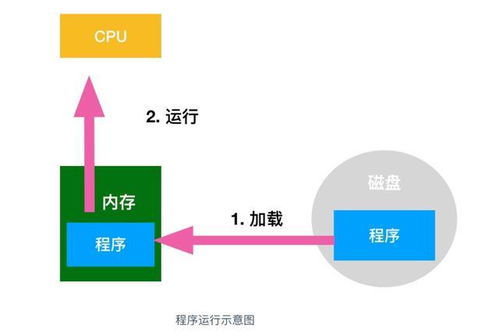

- MapReduce:這是Hadoop最初的計算引擎。它是一種編程模型,用于并行處理大規(guī)模數(shù)據(jù)集。計算任務(wù)被分為兩個階段:

Map(映射)和Reduce(歸約)。Map階段將任務(wù)并行化處理,生成中間鍵值對;Reduce階段則對中間結(jié)果進行匯總。雖然它非常強大且穩(wěn)定,但其基于磁盤的I/O操作模式在迭代計算(如機器學(xué)習(xí))和交互式查詢場景下效率較低。

- YARN (Yet Another Resource Negotiator):作為Hadoop 2.0引入的資源管理平臺,YARN將資源管理與作業(yè)調(diào)度/監(jiān)控功能分離。它負責(zé)集群資源(CPU、內(nèi)存)的統(tǒng)一管理和調(diào)度,允許在Hadoop上運行多種計算框架(如MapReduce、Spark、Tez等),使Hadoop從一個單一的計算系統(tǒng)進化成為一個通用的數(shù)據(jù)操作系統(tǒng)。

Hadoop的服務(wù)定位:Hadoop本質(zhì)上提供了一個低成本、高可靠、可線性擴展的分布式數(shù)據(jù)湖存儲方案(HDFS) 和一個通用資源管理平臺(YARN)。其原生的MapReduce引擎是強大的批處理工具,但如今更多作為存儲和資源底座,支持上層更高效的計算引擎。

二、Spark:高速內(nèi)存計算的革新者

Apache Spark是一個專為大規(guī)模數(shù)據(jù)處理而設(shè)計的快速、通用、可擴展的計算引擎。它最初是為了彌補MapReduce在迭代和交互式計算上的性能瓶頸而誕生的。Spark的核心優(yōu)勢在于其基于內(nèi)存的計算。

- 核心特性與處理能力:

- 速度:Spark通過將中間數(shù)據(jù)緩存到內(nèi)存中,減少了大量磁盤I/O,使得其在迭代算法(機器學(xué)習(xí))和交互式數(shù)據(jù)查詢上的性能比基于磁盤的MapReduce快數(shù)十倍甚至上百倍。

- 易用性:Spark提供了豐富的高級API(支持Scala、Java、Python和R),并引入了易于理解的抽象概念,如彈性分布式數(shù)據(jù)集(RDD) 以及更高級的DataFrame和Dataset,讓開發(fā)者能夠像操作本地集合一樣編寫分布式程序。

- 通用性:Spark設(shè)計了一個統(tǒng)一的引擎,支持多種工作負載。其核心庫包括:

- Spark SQL:用于處理結(jié)構(gòu)化數(shù)據(jù)的模塊,支持使用SQL或DataFrame API進行查詢。

- Spark Streaming:用于處理實時流數(shù)據(jù)(微批處理)。

- MLlib:可擴展的機器學(xué)習(xí)庫。

- GraphX:圖計算庫。

- Structured Streaming:基于Spark SQL引擎構(gòu)建的、更先進的流處理模型。

Spark的服務(wù)定位:Spark本身不提供原生的分布式存儲系統(tǒng)。它是一個純粹的計算引擎,其數(shù)據(jù)處理能力需要建立在存儲系統(tǒng)之上。它最常與HDFS結(jié)合使用,從HDFS讀取數(shù)據(jù),在內(nèi)存中高速處理,再將結(jié)果寫回HDFS或其他存儲系統(tǒng)(如HBase、S3等)。它可以在YARN上運行,由YARN為其分配和管理資源。

三、協(xié)同共生:數(shù)據(jù)處理與存儲的完美搭配

在實踐中,Hadoop和Spark并非互斥的替代品,而是互補的伙伴,形成了經(jīng)典的“Hadoop+Spark”架構(gòu)。

- Hadoop提供“地基”:HDFS提供海量、廉價、可靠的存儲;YARN提供穩(wěn)定的資源池管理和多租戶支持。

- Spark提供“引擎”:作為運行在YARN之上的一個高效計算框架,它從HDFS中讀取數(shù)據(jù),利用內(nèi)存進行高速計算,完成復(fù)雜的批處理、流處理、機器學(xué)習(xí)等任務(wù)。

類比理解:可以想象一個大型圖書館(Hadoop)。HDFS是圖書館的書架和書庫,負責(zé)安全地存放所有書籍(數(shù)據(jù))。YARN是圖書館的管理員,負責(zé)協(xié)調(diào)誰(哪個計算任務(wù))可以在什么時候使用哪個閱覽室(計算資源)。而Spark則是一位極其高效、博學(xué)的研究員(計算引擎),他從書庫(HDFS)借出大批書籍,在自己的高速思維(內(nèi)存)中進行分析、關(guān)聯(lián)和,最終產(chǎn)出研究報告(處理結(jié)果)。MapReduce則是另一位嚴謹?shù)俣容^慢的研究員,他需要頻繁地在書架和書桌間往返(磁盤I/O)。

###

- Hadoop的核心價值在于分布式存儲(HDFS) 和資源調(diào)度(YARN),其原生計算引擎MapReduce適合超大規(guī)模、對延遲不敏感的離線批處理作業(yè)。

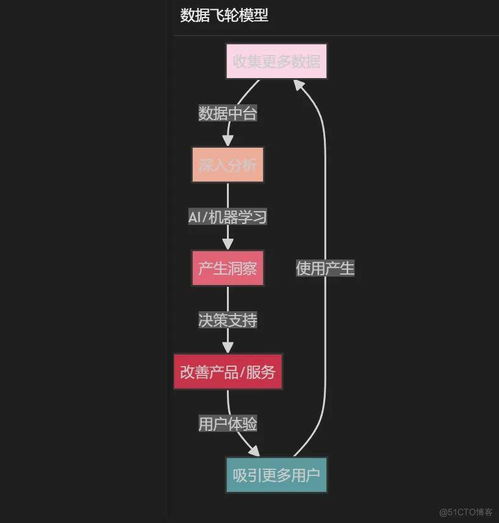

- Spark的核心價值在于基于內(nèi)存的高速、通用計算引擎,它極大地提升了數(shù)據(jù)處理的性能,特別適合迭代計算、交互式查詢和實時流處理。

- 兩者關(guān)系:在現(xiàn)代大數(shù)據(jù)架構(gòu)中,Hadoop(尤其是HDFS和YARN)常常作為Spark的存儲和資源管理底座。Spark憑借其卓越的性能和易用性,已成為大數(shù)據(jù)處理領(lǐng)域事實上的標準計算引擎。它們共同為企業(yè)提供了從海量數(shù)據(jù)存儲到高效數(shù)據(jù)分析的全棧式支持服務(wù),驅(qū)動著數(shù)據(jù)驅(qū)動型決策和智能應(yīng)用的發(fā)展。

如若轉(zhuǎn)載,請注明出處:http://m.520lj.com.cn/product/33.html

更新時間:2026-02-10 07:37:14